Le référencement naturel d’un site web :

Il est faux de dire : Plus de visiteurs = plus de ventes

Le principe du référencement web naturel d’un site internet est d’être pris en compte par Google (sans oublier les 4 à 5 % de parts de marché français des autres moteurs de recherche…), puis d’être classé au mieux en première page selon un certain nombre de mots clés et/ou expressions clé. En général selon le profil de prospects que l’on souhaite attirer sur son site web, et transformer en client bien sûr.

>> Voir les articles sur le référencement…

Il s’agit donc d’attirer des flux de visiteurs, c’est à dire des flux de requêtes vers un site web, et de préférence, de futurs clients.

La sécurité d’un site web :

Les différents types d’attaques sur un site web :

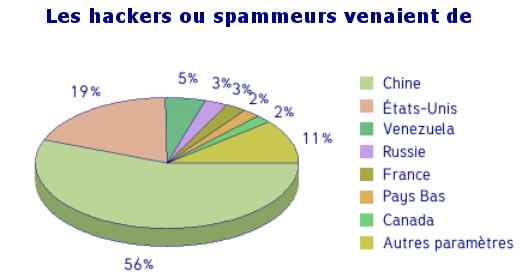

Ils sont nombreux et sans entrer dans les détails, ces types d’attaques informatiques sur les sites web, peuvent être classés en deux groupes :

- Les attaques issues d’un pirate.

- Les attaques issues d’un robot.

Prenons ce deuxième type d’attaque web :

Bien que derrière un robot il y a toujours au moins un programmeur, ce type d’attaque se caractérise par un ciblage très large. C’est la finalité du robot, il est un amplificateur. Pour imager, c’est le même schéma que les antibiotiques à spectre très large : Ces attaques sont des vagues qui vont toucher un grand nombre de sites web, d’une manière relativement “aveugle” et pas vraiment ciblée, car ils vont chercher à insérer un code crypté qui est souvent un lien vers un autre site, la plupart du temps des sites vendant des petites pilules bleues… C’est LE cas d’école. Dans celui-ci, il s’agit pour ces sites, d’avoir un maximum de liens ainsi générés, afin de monter dans le référencement web.

Ces vagues d’attaques sur des millions de sites web ont l’avantage d’être aveugles et elles cherchent la simplicité : Intégrer une ligne de code dans des fichiers la plupart du temps sous racine (le premier niveau du répertoire du domaine), et rarement dans des répertoires plus profonds. Ces robots “recherchent” donc des fichiers ouverts en écriture. En fermant les dossiers et fichiers en écriture, et les laissant en lecture seule, ces attaques sont facilement contrées.

Ces vagues représentent donc une part importante du flux des requêtes sur le réseau internet.

Quels effets sur le référencement ?

Au mieux ces pages infectées mettront plus de temps à s’afficher et au pire on aura une page blanche si le code s’est intégré dans un endroit qui la rend illisible.

Pour le visiteur, impatience et frustration le feront partir, ce qui alimentera le taux de rebond mesuré par Google (un visiteur qui arrive sur une page et qui en repart aussitôt).

Côté Google, ce taux de rebond fera descendre le site web dans le classement. De plus, ces flux malveillants passant par le site web le rendront moins digne de confiance, pire encore s’il est “blacklisté”. La sanction est une descente encore plus rapide dans les résultats de référencement.

La vitesse d’affichage est également ralentie par les flux parasites. Malheureusement elle est aussi mesurée par Google.

Sur son site web, il faut donc rechercher à limiter les flux malveillants, car sécurité et référencement web sont liés.

Tout en aillant présent à l’esprit que la sécurité à 100% n’existe pas : pénétrer un système, n’est qu’une histoire de temps.

Le filtrage des visiteurs

On cherche donc à limiter les flux parasites, ceux qui augmentent la bande passante du site, ainsi que ceux qui augmentent le taux de rebond (utilisé par Google pour le classement des sites web).

Le ciblage des visiteurs.

En conséquence, en plus des flux de visiteurs ciblés que l’on s’efforce d’attirer sur le site web, il faut contrer les flux parasites et malveillants. C’est un peu comme avoir le pied sur l’accélérateur et sur le frein en même temps… Mais bien sûr, les deux ne filtrent pas le même type de flux de requêtes web.

Conclusion :

Un bon référencement web, passe également par la sécurité du site internet en question, car en plus de constamment rechercher à attirer des internautes, il faut freiner les flux malveillants d’autres types de visiteurs, parasites. C’est en quelque sorte, la rançon de la gloire, car trop de flux, tue le flux… Et plus précisément, le classement dans les moteurs de recherche.

Stopper les flux malveillants, permet de limiter le taux de rebond, optimiser la vitesse d’affichage des pages du site web et au final, en stoppant ces requêtes parasites, de mieux filtrer les visiteurs. Si bien sûr on ne souhaite qu’uniquement les internautes qui correspondent au site web…

FAUX :

Plus de visiteurs = plus de ventes

VRAI :

Plus de visiteurs intéressés par le sujet de votre site = plus de prospects.

Des services / des produits recherchés et faciles à acheter depuis le web = plus de ventes.

Car à ce moment là, les prospects deviennent des clients.

POUR PLUS D’INFORMATIONS

OU UNE DEMANDE SUR MESURE :

CONTACTEZ-NOUS…

Articles connexes :

LES FICHES TECHNIQUES :

>> Le principe du référencement naturel…

>> Le référencement web : une histoire de compétition…

>> L’optimisation web pour un bon référencement naturel de votre site internet…

>> Un cas concret d’évolution du référencement d’un site web…

>> Le point sur le référencement naturel…